Des chercheurs de l’Université de Berkeley ont étudié comment YouTube tente depuis un an d’endiguer l’afflux de vidéos complotistes sur sa plateforme – de celles annonçant la fin du monde à celles qui nient le dérèglement climatique (New York Times).

« Le changement climatique est un bobard ». « La Bible a prédit l'élection du président Trump». « Elon Musk est un suppôt du diable qui veut contrôler le monde »... Toutes ces fictions ont pris vie sur YouTube, en partie parce que la plus grande plateforme vidéo du monde les a recommandées à ses utilisateurs.

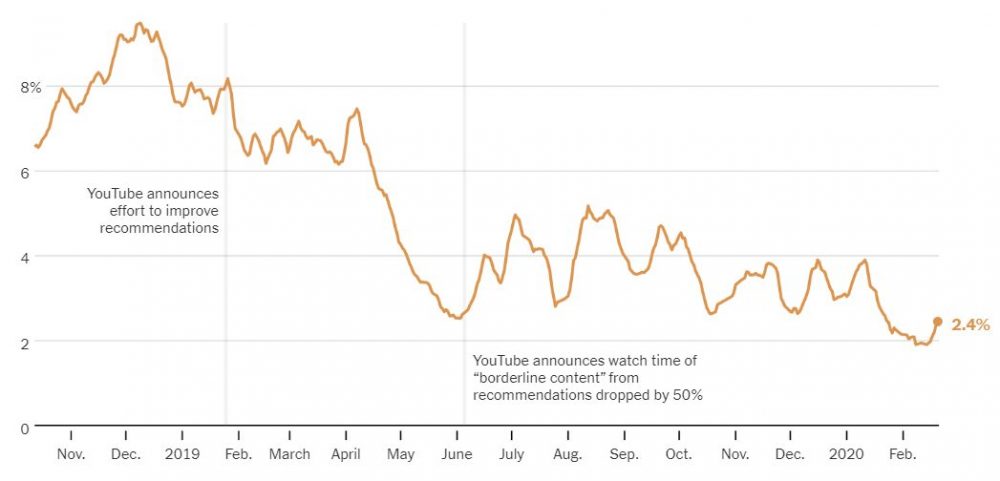

Des années durant, le site a servi d’amplificateur très efficace aux complotistes, ce que même YouTube, plateforme détenue et gérée par Google, a admis. Mais en janvier 2019, ses responsables ont annoncé vouloir limiter la diffusion de vidéos qui risqueraient de « désinformer gravement » ses utilisateurs.

Un an a passé. YouTube favorise nettement moins les théories du complot, mais ses résultats sont inégaux et la plateforme continue de soutenir certaines falsifications. Tel est le résultat d’une étude menée par Marc Faddoul et Hany Farid, chercheurs à l'Université de Californie, à Berkeley, et Guillaume Chaslot (Fondation Mozilla).

Les efforts de YouTube pour enrayer les théories conspirationnistes constituent un test majeur de la capacité de la Silicon Valley à lutter contre la désinformation, en particulier à l'approche des prochaines élections générales américaines. L'étude, couvrant huit millions de recommandations sur 15 mois, fournit une image très claire de cette lutte. Ses résultats mitigés montrent à quel point le défi est grand, même pour des géants comme Google, Facebook ou Twitter.

En ce début d'année 2020, les chercheurs observent que YouTube a presque totalement cessé de recommander certaines fausses informations ou théories du complot – notamment que la Terre serait plate ou que le gouvernement américain aurait perpétré les attaques du 11-Septembre, deux mensonges que le site avait spécifiquement décidé de cibler l'an dernier. Dès juin 2019, YouTube se vantait que le visionnage de ces vidéos avait chuté de 50%.

Mais à peine ces premiers succès étaient-ils enregistrés que le site recommençait à recommander des vidéos conspirationnistes, dont la popularité allait ainsi rebondir puis fluctuer au cours des mois suivants.

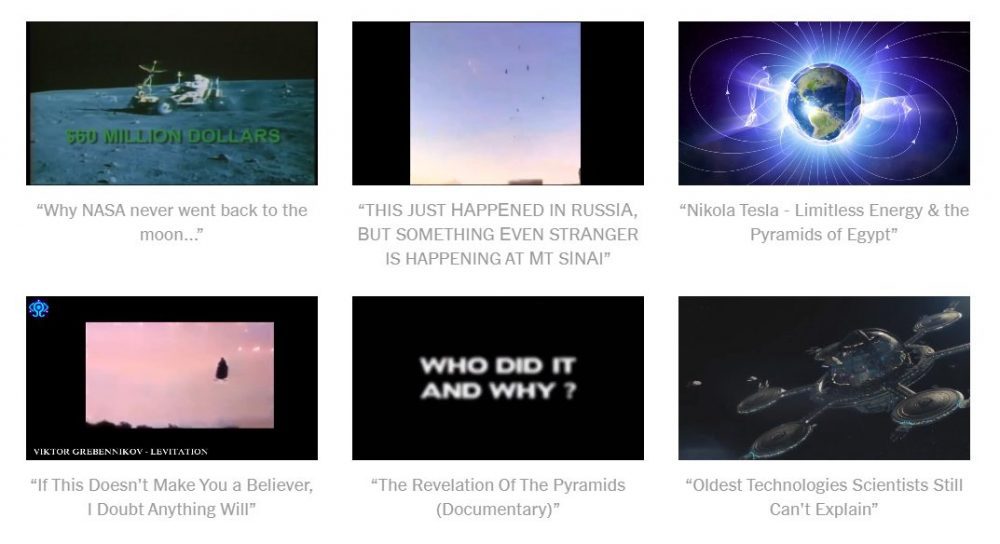

Les chiffres révèlent aussi que d'autres affabulations continuent de prospérer parmi les recommandations de YouTube : citons celles qui attribuent les pyramides aux extraterrestres, qui prétendent que le gouvernement américain cache des technologies secrètes ou que le changement climatique est un bobard.

Les chercheurs en concluent que YouTube a choisi des désinformations à éradiquer et d’autres qui restent autorisées : « Le problème est technologique, mais en fin de compte, il est vraiment éthique, soutient Hany Farid, professeur de Sciences informatiques et coauteur de l'étude. Quand on s’avère capable de réduire à zéro le visionnage de certains contenus, on peut faire beaucoup plus sur beaucoup d’autres plans. Ils disent qu’ils ne peuvent pas. En fait, c’est qu’ils ne veulent pas. »

Selon Farshad Shadloo, un porte-parole de YouTube, les nouvelles recommandations sont conçues pour guider les utilisateurs vers des vidéos fiables qui les satisferont. Il affirme que l’entreprise améliore continuellement l'algorithme générant les recommandations : « L’an passé, il a été modifié plus de 30 fois afin de réduire les recommandations de contenus douteux et de désinformations malfaisantes, notamment sur le changement climatique ou différents types de théories du complot. Ainsi, le visionnage de ces contenus dû à nos recommandations a chuté de plus de 70% aux États-Unis. »

Le puissant algorithme de recommandation de YouTube, qui dirige ses deux milliards d'utilisateurs mensuels vers des vidéos, fait de cette plateforme la nouvelle télévision pour bien des gens à travers le monde. En interne, il a été calculé que ses recommandations sont à l'origine de plus de 70% du milliard d’heures que les gens passent chaque jour à regarder ses vidéos. Son logiciel de recommandation est donc l'un des algorithmes les plus influents de la planète.

Le succès de YouTube a un côté obscur. Les recherches ont montré que ses recommandations promeuvent systématiquement les vidéos clivantes, sensationnalistes et mensongères. D'autres algorithmes travaillent à capter l'attention des gens afin de les exposer à toujours davantage de publicités – c’est le cas du fil d’actualité de Facebook.

L’enjeu est considérable. Chaque jour, YouTube croule sous la publication de fausses informations et de contenus ignobles. Au point que le FBI a récemment qualifié de menace terroriste nationale une telle propagation des théories du complot.

Le mois dernier, un Allemand a posté sur le site une vidéo où il était question de « sociétés secrètes invisibles » utilisant la manipulation mentale pour abuser d'enfants dans des bunkers souterrains. Il a ensuite tué neuf personnes dans une banlieue de Francfort.

Pour étudier YouTube, le professeur Farid et Marc Faddoul, son collègue à Berkeley, se sont associés à Guillaume Chaslot, co-développeur du moteur de recommandation chez Google, passé depuis à la Fondation Mozilla.

À partir d’octobre 2018, les trois chercheurs ont recensé les recommandations proposées à côté des vidéos des 1 000 chaînes d'information les plus fréquentées de YouTube, donnant à leur étude une richesse et une profondeur quasi inédites. Ils ont ensuite forgé un algorithme pour évaluer, sur une échelle de 0 à 1, la probabilité qu'une vidéo colporte une théorie conspirationniste, notamment en analysant son sous-titrage, sa description et les commentaires ajoutés.

Comme bien des tentatives de ce genre, cette étude sur YouTube n’est pas sans défauts. Conclure qu’une vidéo promeut une théorie conspirationniste relève du jugement subjectif. Un algorithme peut donc rapidement s’y tromper.

Pour tenir compte des erreurs, les chercheurs n'ont inclus dans leur étude que les vidéos ayant obtenu un score supérieur à 0,5 sur une échelle de probabilité conspirationniste. Ils ont également pondéré leurs résultats en fonction des notes des vidéos : ainsi, la recommandation d’une vidéo ayant obtenu 0,5 n’est comptée que pour une demi-recommandation, etc.

Autre travers : les recommandations générées par l'algorithme ont été observées en mode déconnexion. Or, ce n'est pas la manière courante dont YouTube est utilisé : les recommandations sont normalement personnalisées en fonction de l'historique de recherche de l'utilisateur lorsqu'il est connecté à son compte. Les chercheurs n'ont pas su corriger ce biais à grande échelle.

Cet obstacle a dissuadé d'autres équipes. Arvind Narayanan, professeur de Sciences informatiques à l'Université de Princeton, a renoncé à étudier l'effet de YouTube sur la radicalisation de ses utilisateurs car, précisément, son laboratoire n’avait pas accès aux recommandations personnalisées. Fin 2019, le professeur Narayanan a critiqué une étude similaire qui concluait que YouTube radicalise peu ses utilisateurs pour ce même motif : elle étudiait les recommandations de l'algorithme indépendamment de tout historique utilisateur.

À la demande du New York Times, le professeur Narayanan s’est penché sur l'étude de Chaslot, Faddoul et Farid. Sa conclusion est qu'il est pertinent de mesurer dans le temps la quantité de théories complotistes recommandées, même sans qu’elles soient personnalisées. Mais si l’on ne peut étudier la personnalisation des recommandations, on ne peut rien déduire quant à l'impact sur les utilisateurs.

Le professeur Narayanan ajoute : « Question plus intéressante : quel effet la promotion de vidéos complotistes via YouTube produit-elle sur les gens et sur la société ? Nous ne pourrons y répondre correctement sans la coopération de YouTube. »

Le porte-parole de YouTube conteste les résultats de l'étude avec ce même argument que les recommandations recensées n’y étaient pas inspirées par des historiques réels, ce qui, assène-t-il, ne représente pas l'utilisation courante du site. Il fait également valoir que les fils d’actualités ont été choisis arbitrairement et qu’ils ne représentent pas ceux qui sont réellement plébiscités par les utilisateurs. Les chercheurs rétorquent avoir choisi les chaînes les plus populaires et les plus recommandées en matière d'information.

Reste que l'étude met en évidence un pot-pourri de paranoïa et de délires. Citons encore les vidéos affirmant que des anges vivent cachés sous la banquise de l’Antarctique (1,3 million de vues), que le gouvernement américain cache des technologies comme la lévitation et l'électricité sans fil (5,5 millions de vues), que les messes basses des politiciens aux funérailles de George Bush confirmaient en direct une révélation majeure (1,3 million de vues) ou que les photos du Rover sur Mars prouvent l’existence d’une civilisation disparue sur la planète rouge (850 000 vues).

Souvent, des publicités accompagnent les vidéos. Elles enrichissent ceux qui les ont mises en ligne et financent leurs prochaines productions. YouTube touche sa quote-part au passage.

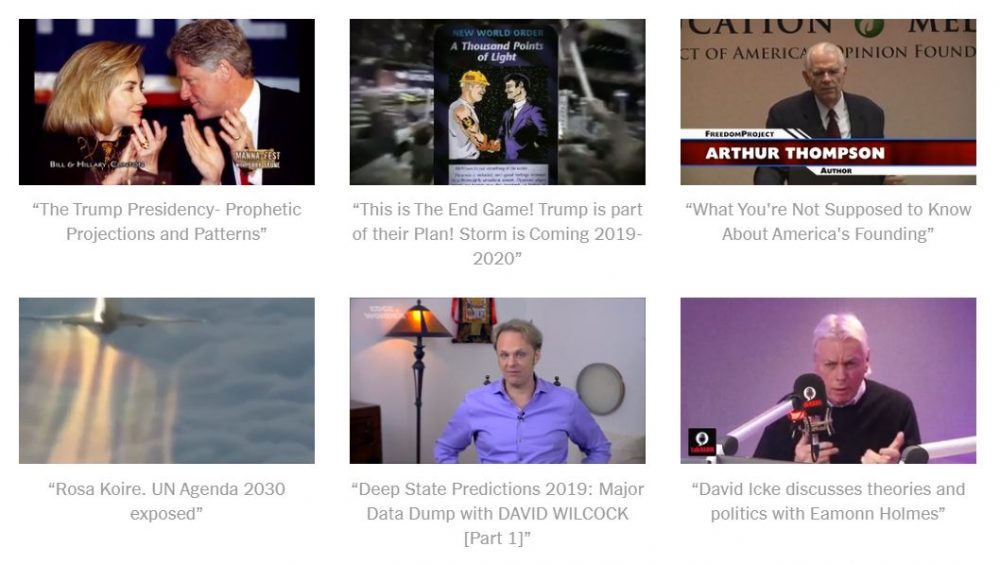

Depuis 2019, YouTube recommande moins certains types de vidéos complotistes, notamment les prophéties annonçant la fin du monde.

Mais une vidéo, totalisant 600 000 vues et intitulée Macron pourrait-il être l'Antéchrist ?, promet les preuves que le président français est le Diable et que l’Apocalypse est proche. Parmi ces preuves, son résultat électoral : 66,06% [en réalité, il a été élu avec 66,09% des suffrages - ndlr] ! Entre décembre 2018 et janvier 2019, YouTube a recommandé 764 fois cette vidéo. Puis ses recommandations ont brusquement disparu.

Au début de 2019, des vidéos de QAnon, basses œuvres des complotistes pro-Trump qui clament que les pédophiles de l’État profond contrôlent l’Amérique, ont bénéficié de milliers de recommandations. Avançant dans l'année, YouTube a fortement réduit ses recommandations, en partie en évitant certaines de ces chaînes très militantes.

YouTube freine la promotion de ces vidéos, en héberge encore beaucoup d’autres, et pour certains sujets, comme l’exploration de la Lune ou le changement climatique, leur adjoint une notice Wikipédia afin de réduire leur potentiel mystificateur.

Une vidéo d’une émission de Fox News, intitulée La vérité sur le réchauffement climatique, recensée 15 240 fois dans l'étude, illustre le défi posé à YouTube dans sa lutte contre la désinformation. Le site déclare vouloir orienter ses utilisateurs vers du journalisme professionnel, mais une chaîne comme Fox News peut diffuser des contenus défaillants. Et parmi ceux-ci, certains ne relèvent pas toujours de théories complotistes bien caractérisées.

Dans cette émission de Fox News, le professeur Michaels, un scientifique directement financé par le géant pétrolier Koch Industries, affirme que le changement climatique ne représente pas une menace, les bulletins météorologiques nationaux étant systématiquement faussés pour surestimer les risques.

« M. Michaels mérite la qualification de conspirationniste, estime Andrew Dessler, professeur en Sciences atmosphériques à l’Université A&M du Texas. Le problème est double : non seulement son savoir est faux, mais surtout il l'emballe dans des accusations qui discréditent toute la science du climat. »

Mis à part ces échanges entre universitaires, les théories du complot recommandées par YouTube proviennent surtout de chaînes de marginaux.

Ainsi de Perry Stone, le cyber-évangéliste qui prétend que la Bible peut prédire l'avenir, que le changement climatique n'est pas une menace et que ceux qui dirigent le monde adorent le Diable : YouTube a régulièrement amplifié les recommandations en faveur de ses vidéos, guidant vers elles près de 8 000 fois les utilisateurs pendant le temps de l'étude. Nombreuses sont celles qui recueillent maintenant des centaines de milliers de vues.

« Je trouve amusant que certains universitaires non croyants assimilent mon enseignement, qui montre le lien entre les prophéties bibliques et leur accomplissement actuel, à un mélange abracadabrant de théories du complot, écrit M. Stone. Le changement climatique n’est qu’une nouvelle façon de parler. Les hommes ont survécu au déluge de Noé, à la destruction de Sodome, au volcan de Pompéi. Quant au fait que les dirigeants mondiaux sont lucifériens, l'information m'a été donnée directement par un milliardaire européen. Je ne divulguerai ni ses sources ni son identité. »

On appréciera.

Source : Jack Nicas, “Can YouTube Quiet Its Conspiracy Theorists?”, New York Times, 2 mars 2020 (tr. fr. : P. M. pour Conspiracy Watch).

Depuis dix-sept ans, Conspiracy Watch contribue à sensibiliser aux dangers du complotisme en assurant un travail d’information et de veille critique sans équivalent. Pour pérenniser nos activités, le soutien de nos lecteurs est indispensable.